In der Zukunft erwartet uns mit Sicherheit Fantastisches, aber in der Gegenwart wirft vor allem das Thema künstliche Intelligenz (KI) einige Fragen auf, die meist mit Moral und Ethik zusammenhängen. Wie konnten uns maschinelle Lernalgorithmen bereits überraschen? Ist es möglich, eine Maschine auszutricksen, und wenn ja, wie schwer ist es? Und, wird es im Endeffekt auf Skynet und die Rebellion der Maschinen hinauslaufen? In diesem Artikel versuchen wir, diese Fragen zu beantworten.

Starke und schwache KI

Zunächst müssen wir zwischen zwei Konzepten unterscheiden: starke und schwache KI. Unter starker KI versteht man eine hypothetische Maschine, die denkfähig ist und sich ihrer eigenen Existenz bewusst ist. Sie kann nicht nur spezifische Aufgaben lösen, sondern auch neue Dinge erlernen.

Schwache KI existiert bereits und ist zur Lösung spezifischer Probleme (Bilderkennung, Autofahren, usw.) in Anwendungen implementiert und wird auch als „maschinelles Lernen“ bezeichnet.

Derzeit können wir noch nicht mit 100%iger Sicherheit sagen, ob starke KI je erfunden werden kann. Expertenbefragungen zufolge müssen wir darauf wahrscheinlich noch rund 45 Jahre warten. Ihrer Meinung nach sollte Fusionsenergie in ungefähr 40 Jahren kommerzialisiert werden können – kurioserweise haben Experten dasselbe bereits vor 50 Jahren gesagt.

Was könnte schief gehen?

Es ist noch immer unklar, ob und wann starke KI entwickelt werden wird; Fakt ist, dass schwache KI längst existiert und in vielen Bereichen bereits vermehrt eingesetzt wird – Tendenz steigend. Maschinelles Lernen ermöglicht uns, praktische Aufgaben ohne offensichtliche Programmierung zu bewältigen und lernt aus Fallbeispielen. Weitere Informationen finden Sie in unserem Artikel „Kurz und knapp: Wie maschinelles Lernen funktioniert„.

Maschinen lernen konkrete Probleme zu lösen, sodass das resultierende mathematische Modell – was wir einen „lernenden“ Algorithmus nennen – nicht dazu in der Lage ist ein plötzliches Verlangen zu entwickeln, die Menschheit zu unterdrücken (oder zu retten). Mit anderen Worten: wir müssen keine Angst vor einem Skynet-Szenario aufgrund schwacher KI haben. Dennoch gibt es einige Dinge, die schiefgehen könnten.

1. Böse Absichten

Wenn die Menschheit einer Drohnen-Armee mithilfe maschineller Lernalgorithmen beibringt, Menschen zu töten, könnte das Resultat dann ethisch sein?

Im letzten Jahr sorgte dieses Thema für einen Skandal. Denn derzeit entwickelt Google Software für ein militärisches Projekt namens Project Maven, bei dem auch Drohnen involviert sind. In ferner (oder naher) Zukunft könnte diese Software auch dabei helfen, völlig autonome Waffensysteme zu entwickeln.

Das Ergebnis? 12 Google-Mitarbeiter traten aus Protest zurück und 4000 weitere unterschrieben eine Petition, in der das Unternehmen dazu aufgefordert wurde, den Vertrag mit dem Militär aufzulösen. Mehr als 1000 bekannte Wissenschaftler in den Bereichen KI, Ethik und IT schrieben einen offenen Brief an Google, in dem sie das Unternehmen darum baten, das Projekt aufzugeben und ein internationales Abkommen zu unterstützen, das autonome Waffen verbietet.

2. Entwickler-Tendenzen

Selbst wenn Entwickler maschineller Lernalgorithmen keine Absichten haben Schaden anzurichten, wollen viele von ihnen lediglich schnell und viel Geld verdienen – das heißt, dass ihre Algorithmen zum Nutzen der Entwickler erstellt werden, nicht unbedingt zum Wohle der Gesellschaft. So könnten einige medizinische Algorithmen beispielsweise dafür sorgen, dass teure Behandlungen denjenigen mit den besten Ergebnissen für den Patienten vorgezogen werden.

Manchmal hat die Gesellschaft selbst kein Interesse daran, dass sich ein Algorithmus in ein moralisches Vorbild verwandelt. Betrachtet man beispielsweise die Verbindung zwischen der zugelassenen Verkehrsgeschwindigkeit und der Todesrate bei Autounfällen, könnte man autonome Fahrzeuge zukünftig so programmieren, dass sie nicht schneller als 15 Meilen pro Stunde fahren, was die Zahl der Verkehrstoten quasi auf Null reduzieren würde, aber wiederum andere Vorteile der Verwendung eines Autos negieren würde, an denen viele Verbraucher schlichtweg nicht interessiert sind.

3. System-Parameter umfassen nicht immer ethische Prinzipien

Im Grunde genommen wissen Computer standardmäßig nichts über Ethik. Ein Algorithmus kann ein Staatsbudget mit dem Ziel „Maximierung des BIP/der Arbeitsproduktivität oder Lebenserwartung“ erstellen, aber ohne ethische Einschränkungen, die im Modell enthalten sind, würde der Algorithmus wahrscheinlich die Budgets für Schulen, Krankenhäuser und Umweltfragen schlichtweg aus der Welt schaffen, weil sie das BIP nicht aktiv steigern.

Je nachdem, welches Ziel dem Algorithmus gesetzt wird, könnte er so beispielsweise auch entscheiden, alle arbeitsunfähigen Personen „zu beseitigen“, um die Produktivität zu erhöhen.

Aus diesem Grund müssen ethische Fragen von Anfang an mit einbezogen werden.

4. Ethische Relativität

Die Ethik verändert sich im Laufe der Zeit stetig. So können sich beispielsweise die Meinungen zu Themen wie LGBT-Rechten und interkultureller oder interkasteartiger Ehe innerhalb einer Generation signifikant verändern.

Darüber hinaus kann Ethik zwischen verschiedenen Gruppen innerhalb des gleichen Landes oder in verschiedenen Ländern variieren. Zum Beispiel ist in China die Verwendung der Gesichtserkennung zur Massenüberwachung bereits zur Norm geworden. Andere Länder haben eventuell eine vollkommen andere Meinung zu diesem Thema, die oftmals situationsabhängig ist.

Auch das politische Klima spielt eine entscheidene Rolle. So hat zum Beispiel der Kampf gegen den Terrorismus einige ethische Normen und Ideale in vielen Ländern erheblich – und unglaublich schnell – verändert.

5. Maschinelles Lernen verändert die Menschheit

Maschinelle Lernsysteme empfehlen Ihnen neue Filme basierend auf Ihren Bewertungen anderer Filme und nach dem Vergleich Ihrer Präferenzen mit denen anderer Nutzer. Manche Systeme sind darin bereits ziemlich gut.

Ein solches System ändert und schränkt Ihre Präferenzen mit der Zeit ein; denn ohne es wären Sie mehr oder weniger gezwungen, ab und an schlechte Filme sowie Filme unerwünschter Genres zu ertragen. Mithilfe KI wird Ihnen quasi eine Reihe ausgewählter Inhalte, die ausschließlich auf Ihre Vorlieben zugeschnitten sind, schmackhaft präsentiert und letztendlich konsumieren Sie nur noch das, was Ihnen angeboten wird.

Interessant ist auch, das wir oft nicht einmal merken, dass wir von Algorithmen manipuliert werden. Das Film-Beispiel ist nicht allzu beängstigend, aber stellen Sie sich das Ganze nun im Bereich der Nachrichten und Propaganda vor.

6. Falsche Korrelationen

Eine falsche Korrelation tritt dann auf, wenn Dinge, die in keinerlei Beziehung zueinanderstehen, ein sehr ähnliches Verhalten zeigen, was dann die Illusion erzeugen kann, dass diese beiden Dinge auf irgendeine Art und Weise miteinander verbunden sind. Wussten Sie, dass der Verbrauch von Margarine in den USA stark von der Scheidungsrate in Maine abhängig ist?

Natürlich werden Menschen aus Fleisch und Blut, die sich auf ihre persönliche Erfahrung und menschliche Intelligenz verlassen, sofort erkennen, dass eine direkte Verbindung zwischen diesen beiden Dingen äußerst unwahrscheinlich ist. Ein mathematisches Modell besitzt ein solches Wissen allerdings nicht – es lernt ganz einfach und verallgemeinert Daten.

Ein gut bekanntes Beispiel ist eine Software, die Patienten nach ihrer Dringlichkeit für den Bezug ärztlicher Hilfe eingestuft hatte und zu dem Schluss kam, dass Asthmapatienten mit einer Lungenentzündung nicht so hilfebedürftig sind wie Lungenentzündungspatienten ohne Asthma. Mithilfe der Daten, die die Software untersuchte, stufte sie das Sterberisiko der Asthmapatienten als deutlich geringer ein und gab ihnen daher keine Priorität. Tatsächlich waren ihre Sterblichkeitsraten so niedrig, weil sie aufgrund ihres Gesundheitszustands, immer sofortige Hilfe in medizinischen Einrichtungen erhielten.

7. Feedback Loops

Feedback Loops sind noch schlimmer als falsche Korrelationen. Ein Feedback Loop beschreibt eine Situation, in der die Entscheidungen eines Algorithmus die Realität beeinflussen, was den Algorithmus wiederum davon überzeugt, dass seine Schlussfolgerung korrekt ist.

Zum Beispiel schlug ein Programm zur Verbrechensbekämpfung in Kalifornien vor, dass die Polizei aufgrund der Kriminalitätsrate – die Zahl der aufgezeichneten Verbrechen – mehr Beamte in afroamerikanische Viertel schicken sollte. Doch die hohe Anzahl der Polizeiautos in einem der Viertel führte dazu, dass die Anwohner Straftaten häufiger meldeten, was im Umkehrschluss zu einer höheren Kriminalitätsrate führte. Das Ergebnis? Noch mehr Beamte wurden in die Gegend geschickt.

8. „Kontaminierte“ oder „vergiftete “ Referenzdaten

Die Ergebnisse algorithmischer Lernprozesse hängen weitgehend von Referenzdaten ab, die die Grundlage der Prozesse bilden. Die Daten können jedoch durch Zufall oder durch böswillige Absicht (der letztere Fall wird für gewöhnlich als „Vergiftung“ bezeichnet) nicht angemessen oder verfälscht sein.

Hier ein Beispiel für unbeabsichtigte Probleme mit Referenzdaten: Wenn die Daten, die als Trainingbeispiel für einen Einstellungsalgorithmus verwendet werden, von einem Unternehmen mit rassistischen Einstellungspraktiken bezogen werden, wird auch der Algorithmus rassistische Präferenzen haben.

Microsoft hat einem Chatbot vor geraumer Zeit beigebracht, mit den Nutzern auf Twitter zu kommunizieren. Das Projekt musste allerdings in weniger als 24 Stunden abgebrochen werden, da einige Nutzer dem Bot schnell beigebracht hatten das Buch „Mein Kampf“ zu zitieren.

"Tay" went from "humans are super cool" to full nazi in <24 hrs and I'm not at all concerned about the future of AI pic.twitter.com/xuGi1u9S1A

— gerry (@geraldmellor) March 24, 2016

Es folgt ein weiteres Beispiel für „vergiftete“ Daten maschineller Lernalgorithmen: Ein mathematisches Modell in einem Computervirus-Analyselabor verarbeitet durchschnittlich 1 Million Dateien pro Tag, sowohl gutartige als auch bösartige. Die Bedrohungslandschaft ändert sich ständig, sodass Modelländerungen für installierte Produkte auf der Kundenseite in Form von Updates der Antivirus-Datenbanken ausgeliefert werden.

Ein Hacker kann allerdings weiterhin bösartige Dateien erzeugen, die gutartigen Dateien sehr ähnlich sind, und diese an das Labor senden. Auf diese Weise löst sich die Grenze zwischen bedenkenlosen und schädlichen Dateien nach und nach auf, wodurch das Modell degradiert wird und möglicherweise ein False Positiv ausgelöst wird.

Aus diesem Grund verfügt Kaspersky Lab über ein mehrschichtiges Sicherheitsmodell und verlässt sich nicht ausschließlich auf maschinelle Lernalgorithmen. Unsere Antiviren-Experten haben immer ein Auge darauf, was die Maschine macht.

9. Algorithmen austricksen

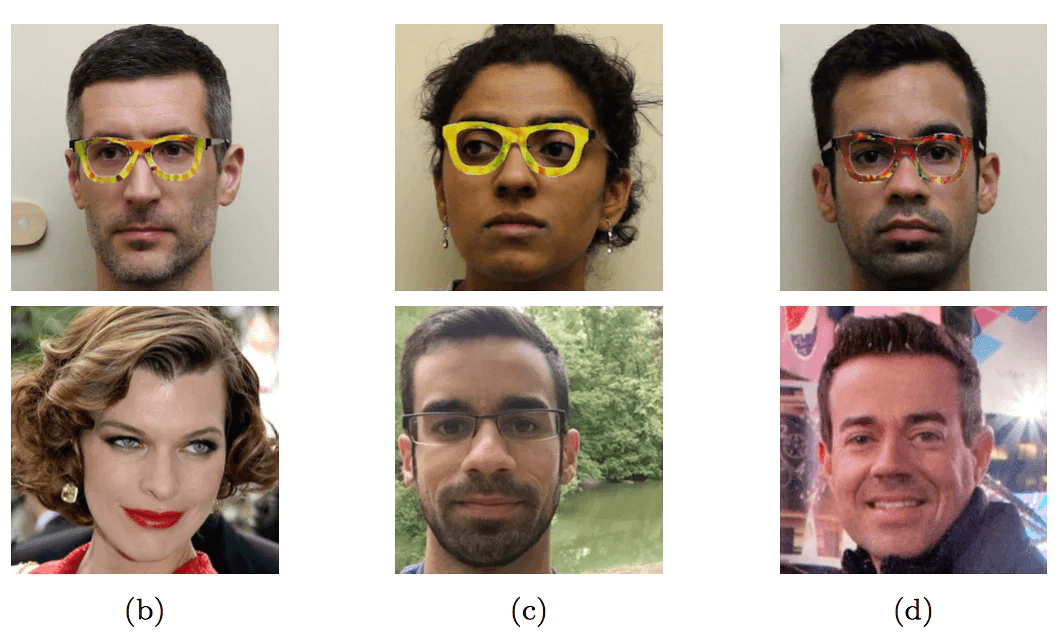

Selbst ein gut funktionierendes mathematisches Modell, das auf angemessenen Daten aufbaut, kann ausgetrickst werden, wenn man weiß, wie es geht. Eine Forschergruppe fand beispielsweise heraus, wie man einen Gesichtserkennungsalgorithmus mit einer speziellen Brille austricksen könnte, die minimale Verzerrungen in das Bild einbringen und somit das Endergebnis vollständig verändern würde.

Mit einer speziell gefärbten Brillenfassung haben Forscher einen Gesichtserkennungsalgorithmus ausgetrickst und ihn im Glauben gelassen, jemand anderes zu sein

Selbst in den einfachsten Situationen, kann eine Maschine kinderleicht mit Methoden ausgetrickst werden, die einem Laien ganz einfach nicht bekannt sind.

Die ersten drei Schilder werden als Geschwindigkeitsbegrenzung (45km/h) erkannt, das letzte Schild als STOP-Schild

Abgesehen davon müssen Änderungen nicht signifikant sein, um ein mathematisches Modell, das auf maschinellen Lernalgorithmen basiert, aus dem Gleichgewicht zu bringen – minimale Veränderungen, die für das menschliche Auge nicht wahrnehmbar sind, reichen bereits aus.

Durch minimale Veränderungen ist der Panda links auf einmal ein Gibbon

Solange wir Menschen schlauer sind als die meisten Algorithmen, können wir sie auch weiterhin austricksen. Denken Sie beispielsweise an zukünftige maschinelle Lernalgorithmen, mit deren Hilfe Gepäckröntgenaufnahmen am Flughafen analysiert werden und nach Waffen gesucht wird. Terroristen mit ein wenig Köpfchen werden in der Lage sein, ein Objekt mit einer bestimmten Form neben eine Waffe zu legen und die Waffe so unsichtbar zu machen.

Wer sind die Schuldigen und was kann getan werden?

Im Jahr 2016 veröffentlichte die Big Data Working Group der „Obama Administration“ einen Bericht, der vor „dem Potenzial der Diskriminierungskodierung bei automatisierten Entscheidungen“ warnte. Darüber hinaus enthielt der Bericht einen Appell an die Entwicklung von Algorithmen, die nach dem Grundsatz der Chancengleichheit funktionieren sollten.

Leichter gesagt als getan.

Zum einen sind mathematische maschinelle Lernmodelle schwierig zu testen und auszubessern: zwar werden reguläre Programme Schritt für Schritt analysiert und getestet, beim maschinellen Lernen hingegen hängt allerdings alles von der Größe des Lernbeispiels ab, das nun mal nicht unendlich sein kann.

So erkannte und kennzeichnete die App Google Photo farbige Menschen beispielsweise als Gorillas. Das Ganze endete, wie Sie sich vermutlich vorstellen können, in einem Skandal und Google versprach, den Algorithmus auszubessern. Nach drei Jahren ist es Google noch immer nicht gelungen etwas Besseres zu finden, als das Markieren von Objekten als Gorillas, Schimpansen oder Affen zu untersagen.

Zum anderen ist es schwer, die Entscheidungen maschineller Lernalgorithmen zu verstehen und zu erklären. Ein neuronales Netzwerk arrangiert intern Koeffizienten, um zu einer korrekten Antwort zu gelangen – aber wie? Und was kann getan werden, um die Antwort zu ändern?

Untersuchungen aus dem Jahr 2015 haben gezeigt, dass Frauen Google AdSense-Anzeigen für gut bezahlte Jobs viel seltener angezeigt bekommen als Männer. Auch der Same-Day-Lieferservice von Amazon ist in afroamerikanischen Stadtvierteln oft nicht verfügbar. In beiden Fällen waren Vertreter der Unternehmen nicht in der Lage, die von den Algorithmen getroffenen Entscheidungen plausibel zu erklären.

Im Endeffekt gibt es keinen Schuldigen, den wir an den Pranger stellen können, also müssen wir neue Gesetze verabschieden und neue ethische Regeln für die Roboterechnik ins Leben rufen. Im Mai 2018 hat Deutschland einen ersten Schritt in diese Richtung getan und ethische Regeln für selbstfahrende Autos erlassen:

- Sachschaden geht vor Personenschaden: In Gefahrensituationen hat der Schutz menschlichen Lebens immer höchste Priorität.

- Bei unausweichlichen Unfallsituationen ist jede Qualifizierung von Menschen nach persönlichen Merkmalen (Alter, Geschlecht, körperliche oder geistige Konstitution) unzulässig.

Für uns ist aber vor allem folgender Grundsatz besonders wichtig:

- Das automatisierte und vernetzte Fahren ist ethisch geboten, wenn die Systeme weniger Unfälle verursachen als menschliche Fahrer (positive Risikobilanz).

Selbstverständlich werden wir uns zukünftig mehr und mehr auf maschinelle Lernalgorithmen verlassen; ganz einfach weil sie viele Aufgaben besser bewältigen können als wir Menschen. Daher ist es wichtig, mögliche Fehler und Probleme im Hinterkopf zu behalten und zu versuchen, diese bereits in der Entwicklungsphase zu antizipieren. Darüber hinaus ist es wichtig, immer ein Auge auf die Leistung der Algorithmen zu werfen, falls im Fall der Fälle etwas schief gehen sollte.

HuMachine

HuMachine

Tipps

Tipps