KI präsentiert nicht nur endlos neue Möglichkeiten, sie hat auch viele neue Bedrohungen im Schlepptau. Mit generativer KI können böswillige Akteure Deepfakes und gefälschte Websites erstellen, Spam verschicken und sich sogar als deine Freunde und Familie ausgeben. In diesem Artikel erfährst du, wie neuronale Netze für Betrug und Phishing eingesetzt werden. Und natürlich geben wir Tipps, wie du dich schützen kannst. Weitere Details zu KI-gestützten Phishing-Methoden findest du im vollständigen Bericht auf Securelist.

Pig Butchering, Catfishing und Deepfakes

KI-Bots können sich als echte Menschen ausgeben und werden gerne für Betrügereien mit romantischem Beigeschmack verwendet. Betrüger erstellen Fantasiepersonen, um mit mehreren Opfern gleichzeitig zu kommunizieren und starke emotionale Verbindungen aufzubauen. Solche Chats können sich über Wochen oder Monate hinziehen. Sie beginnen mit harmlosem Flirt und entwickeln sich allmählich zu Diskussionen über „lukrative Anlagemöglichkeiten“. Durch die vermeintlich persönliche Beziehung wird bei Opfern jeglicher Verdacht zerstreut. Das böse Erwachen folgt aber, sobald das Opfer sein Geld in ein betrügerisches Projekt investiert hat. Solche üblen Machenschaften sind unter dem Namen „Pig Butchering“ bekannt, das wir in einem anderen Artikel ausführlich beschrieben haben. Früher gab es in Südostasien riesige „Betrugsfarmen“, die Tausende von Menschen beschäftigten. Inzwischen setzen solche Betrügereien zunehmend auf KI.

Dank neuronaler Netze ist auch Catfishing kinderleicht geworden. Dabei erstellen Betrüger eine falsche Identität oder geben sich als echte Person aus. Generative neuronale Netze können heute das Aussehen, die Stimme oder den Schreibstil einer Person mit hinreichender Genauigkeit nachahmen. Ein Betrüger sammelt öffentlich verfügbare Informationen über eine Person und füttert die KI damit. Dabei kann wirklich alles nützlich sein: Fotos, Videos, öffentliche Postings, Kommentare, Informationen über Verwandte, Hobbys, Alter und so weiter.

Wenn dir also ein Familienmitglied oder Freund von einem neuen Konto aus schreibt und beispielsweise Geld leihen will, ist es wahrscheinlich gar kein Verwandter oder Freund. Wende dich in solchen Fällen am besten über einen anderen Kanal an die echte Person. Du kannst z. B. anrufen und direkt fragen, ob alles in Ordnung ist. Ratsam ist auch, ein paar persönliche Fragen zu stellen, auf die ein Betrüger im Internet oder in deinen früheren Nachrichten keine Antwort finden kann.

Der überzeugende Identitätswechsel mit Textnachrichten ist jedoch nur ein Teil des Problems – viel bedrohlicher sind Audio- und Video-Deepfakes. Wir haben kürzlich darüber berichtet, wie Betrüger in sozialen Medien Deepfakes von beliebten Bloggern und Krypto-Investoren verwenden. Die gefälschten Prominenten laden ihre Fans zu „persönlichen Beratungsgesprächen“ oder „exklusiven Investment-Chats“ ein oder versprechen Geldpreise und teure Werbegeschenke.

Social Media ist jedoch nicht der einzige Ort, an dem sich Deepfakes pudelwohl fühlen. Sie werden auch für Video- und Audioanrufe in Echtzeit generiert. Anfang des Jahres verlor eine Frau aus Florida 15.000 US-Dollar. Sie war davon überzeugt, mit ihrer Tochter zu sprechen, die angeblich einen Autounfall hatte. Die Betrüger verwendeten einen realistischen Deepfake der Stimme ihrer Tochter und ließen sie sogar weinen – alles täuschend echt.

Experten von Kaspersky GReAT haben im Darkweb Anzeigen gefunden, die Video- und Audio-Deepfakes in Echtzeit anbieten. Der Preis hängt von der Qualität und Länge der Inhalte ab. Sprach-Deepfakes gibt es schon ab 30 US-Dollar, Videos ab 50 Dollar. Noch vor wenigen Jahren waren solche Dienste fast unerschwinglich (bis zu 20.000 US-Dollar pro Minute) und eine Echtzeitgenerierung gab es damals noch gar nicht.

Heutzutage gibt es alles, was das Herz begehrt: Gesichtertausch in Echtzeit für Videokonferenzen oder Messaging-Apps, Gesichtertausch zur Identitätsüberprüfung oder den Austausch eines Bildes auf einem Telefon oder anderen virtuellen Geräten.

Betrüger bieten auch Tools für die Lippensynchronisierung gesprochener Texte in Videos an (sogar in Fremdsprachen) sowie Tools, mit denen Stimmen in Ton und Tonlage an die gewünschte Emotion angepasst werden können.

Unsere Experten vermuten jedoch, dass viele dieser Darkweb-Anzeigen selbst Betrug sind. Sie sollen andere Möchtegern-Betrüger dazu bringen, für Dienste zu bezahlen, die es in Wirklichkeit gar nicht gibt.

So kannst du dich schützen

- Hast du Online-Bekannte, die du noch nie persönlich getroffen hast? Dann solltest du ihnen nicht vertrauen. Vielleicht chattest du schon eine ganze Weile mit einer fremden Person und ihr versteht euch einfach super. Besondere Vorsicht ist angesagt, wenn es um Krypto, Investitionen oder andere Geldanlagen geht.

- Solche Angebote können unglaublich attraktiv klingen, besonders wenn sie von Prominenten oder großen Unternehmen stammen und über Social Media geteilt werden. Schau immer auf ihren offiziellen Accounts nach, um die Informationen genau zu überprüfen. Wenn dir ein Werbegeschenk oder ein Geldpreis angeboten wird und du plötzlich aufgefordert wirst, eine Gebühr, Steuern oder Versandkosten zu zahlen oder deine Kreditkartendaten einzugeben, solltest du die Unterhaltung sofort abbrechen!

- Wenn du von Freunden oder Verwandten mit ungewöhnlichen Anfragen kontaktiert wirst, wende dich auf einem anderen Weg, z. B. per Telefon, an sie. Frage sicherheitshalber nach etwas, über das ihr euch beim letzten persönlichen Treffen unterhalten habt. Mit engen Freunden und Verwandten kannst du im Voraus ein Codewort vereinbaren, das sonst niemand kennt. Wenn ihr euren Standort miteinander teilt, schau nach, wo sicher die Person gerade befindet und lass dir den Standort bestätigen. Und Vorsicht bei Manipulationsversuchen durch künstlich erzeugte „Eile“. Der Betrüger oder die KI erzählen dir möglicherweise, dass es dringend ist und dass sie keine Zeit für überflüssige Fragen haben.

- Wenn du an der Echtheit eines Videoanrufs zweifelst, bitte die Person, den Kopf zur Seite zu drehen oder eine schwierige Handbewegung auszuführen. Normalerweise scheitern Deepfakes an solchen Anfragen oder sie zeigen etwas Absurdes an. Weitere Warnsignale sind, wenn die Person nicht zwinkert oder die Lippenbewegungen oder der Gesichtsausdruck seltsam erscheinen.

- Für Bankkartennummern, Einmalcodes oder andere vertrauliche Informationen gilt: Niemals diktieren oder auf andere Weise weitergeben!

Ein Beispiel für einen Deepfake, der „versagt“, wenn der Kopf gedreht wird. Quelle

Automatisierte Anrufe

Diese Betrugsmethode ist besonders effizient, da kein direktes Gespräch mit potenziellen Opfern stattfindet. Betrüger verwenden KI, um automatisierte Anrufe von Banken, Mobilfunkanbietern oder Behörden zu fälschen. Am anderen Ende der Leitung spricht ein Bot, der sich als Support-Mitarbeiter ausgibt. Da viele seriöse Unternehmen automatisierte Sprachassistenten verwenden, erregen solche Anrufe keinen Verdacht. Allerdings rufen echte Unternehmen niemals an, um dir mitzuteilen, dass dein Konto gehackt wurde, oder um nach einem Bestätigungscode zu fragen.

Bei solchen Anruf heißt es: Ruhe bewahren! Lass dich durch Behauptungen wie „Ihr Konto wurde gehackt“ oder „Ihr Geld wurde gestohlen“ nicht in Panik versetzen. Leg einfach auf, schau auf der Website des Unternehmens nach der offiziellen Telefonnummer und erkundige dich dort, was los ist. Beachte, dass an aktuellen Betrugsmethoden mehrere Bösewichte beteiligt sein können, die dich nacheinander kontaktieren. Sie können von verschiedenen Nummern aus anrufen, SMS-Nachrichten senden und sich als Bankangestellte, Beamte oder Polizisten ausgeben.

Phishing in Chatbots und KI-Agenten

Anstelle der bekannten Suchmaschinen werden heutzutage immer häufiger Chatbots (ChatGPT, Gemini usw.) verwendet. Welche Risiken gibt es dabei? Große Sprachmodelle werden mit Benutzerdaten trainiert, und es gab schon Fälle, in denen populäre Chatbots den Nutzern Phishing-Websites vorgeschlagen haben. Wenn KI-Agenten die Websuche einsetzen, wird eine Verbindung zu Suchmaschinen hergestellt, und in den Ergebnissen können auch Phishing-Links auftauchen.

Bei einem kürzlich durchgeführten Experiment wurde der KI-Agent im Comet Browser von Perplexity mit einer gefälschten E-Mail-Nachricht überlistet. Die E-Mail stammte angeblich von einem Investmentmanager von Wells Fargo, einer der größten Banken der Welt. Die Forscher verschickten die E-Mail von einem frisch angelegten Konto bei Proton Mail. Die Nachricht enthielt einen Link zu einer echten Phishing-Seite, die seit mehreren Tagen aktiv war, aber von Google Safe Browsing noch nicht als bösartig markiert worden war. Der KI-Agent durchsuchte den Posteingang des Nutzers und markierte die Nachricht als „Anfrage von deiner Bank“. Ohne weitere Überprüfung folgte der Agent dem Phishing-Link, öffnete die gefälschte Anmeldeseite, forderte den Nutzer auf, seine Anmeldedaten einzugeben und half sogar dabei, das Formular auszufüllen! Die KI verbürgte sich sozusagen für die Phishing-Seite. Der Nutzer hatte weder die E-Mail-Nachricht des verdächtigen Absenders noch den Phishing-Link gesehen. Stattdessen leitete ihn der hilfsbereite KI-Assistent direkt auf die Seite, auf der seine Anmeldedaten abgefragt wurden.

Im selben Experiment verwendeten die Forscher die KI-basierte Webentwicklungsplattform Loveable und erstellten damit eine gefälschte Website, die einen Walmart-Shop nachahmte. Anschließend besuchten sie diese Website im Comet Browser – wie es auch ein argloser Nutzer leicht tun könnte, wenn er auf einen Phishing-Link oder eine Phishing-Anzeige hereinfällt. Sie baten den KI-Agenten, eine Apple Watch zu kaufen. Der Agent analysierte die Fake-Website, fand ein „Schnäppchen“, legte die Uhr in den Warenkorb, gab die im Browser gespeicherte Adresse und die Bankkartendaten ein und schloss den „Kauf“ ab – alles, ohne nach einer Bestätigung zu fragen. Wäre dies eine betriebsfähige Fake-Website gewesen, hätte der Nutzer nicht nur Geld verloren, als Zugabe hätten die Betrüger auch noch seine Bankdaten bekommen.

Leider verhalten sich KI-Agenten im Internet bisher wie naive Anfänger und fallen sehr leicht auf Social Engineering herein. Wir haben bereits ausführlich darüber gesprochen, welche Risiken die KI-Integration in Browser mit sich bringt und wie sie minimiert werden können. Nur zur Erinnerung: Damit dich ein leichtgläubiger Assistent nicht in Verlegenheit bringt, solltest du alle von ihm bereitgestellten Informationen kritisch prüfen, die Berechtigungen für KI-Agenten einschränken und eine zuverlässige Sicherheitslösung installieren, die den Zugriff auf schädliche Websites blockiert. zuverlässige Sicherheitslösung

KI-generierte Phishing-Websites

Nachlässig gestaltete Phishing-Websites mit aufdringlicher Werbung gehören der Vergangenheit an. Heutzutage geben Betrüger ihr Bestes, um realistische Fälschungen anzufertigen. Auch Fake-Websites können das https-Protokoll verwenden, Benutzervereinbarungen und Warnungen zur Cookie-Nutzung präsentieren und ein annehmbares Design haben. Durch KI-gestützte Tools ist die Erstellung solcher Websites viel günstiger und schneller geworden (es geht wie auf Knopfdruck). Auf Links zu solchen Websites kannst du überall stoßen: in SMS-Nachrichten, in E-Mails, in sozialen Netzwerken oder auch in Suchergebnissen.

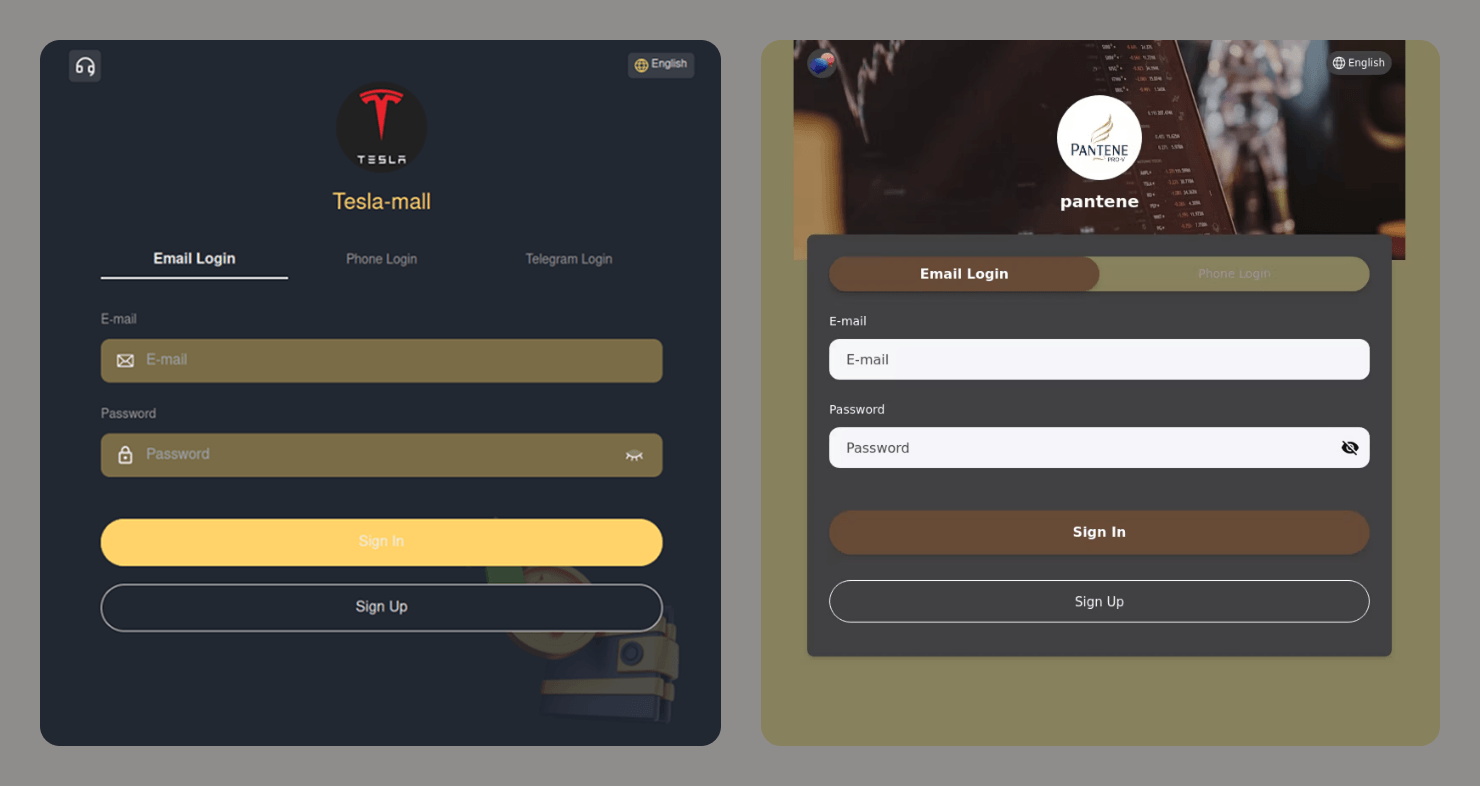

Formulare zur Eingabe von Anmeldeinformationen auf betrügerischen Websites, die Tesla und Pantene imitieren

So erkennst du Phishing-Websites

- Überprüfe URL, Titel und Inhalt auf Tippfehler.

- Schau nach, wie lange die Domäne der Website bereits registriert ist. Dies kannst du hier überprüfen.

- Achte auf die Sprache. Wird versucht, dir Angst zu machen oder dich zu beschuldigen? Versucht jemand, dich anzulocken oder dich zu bestimmten Aktionen zu drängen? Jegliche emotionale Manipulation ist ein deutliches Warnsignal.

- Aktiviere die Link-Untersuchung in einer unserer Sicherheitslösungen.

- Wenn der Browser vor einer unsicheren Verbindung warnt, verlasse die Website. Legitime Websites verwenden das https-Protokoll.

- Suche im Internet nach dem Namen der Website und vergleiche die angegebene URL mit der URL aus den Suchergebnissen. Vorsicht! Möglicherweise zeigen Suchmaschinen gesponserte Phishing-Links ganz oben auf der Ergebnisseite an. Stelle sicher, dass es neben dem Link kein Label mit der Aufschrift „Anzeige“ oder „Gesponsert“ gibt.

In den folgenden Artikeln erfährst du mehr über den sicheren Einsatz von KI:

phishing

phishing

Tipps

Tipps